本文是一篇较早的文章(2011),所以重点放在了对MF模型的特例化。即本文可以理解为MF的特例(或简化), 把两个隐因子(low-rank)矩阵,改成了原矩阵乘以一个sparse的列加权矩阵W。并且对权重矩阵进行一定的限制,如利用l1 norm控制权重矩阵竟可能多的元素是0(即稀疏化),另外,W的对角元素为0,避免自己对自己的影响。

至此,就可以利用一般的梯度下降方法求得W。(也可以通过求W的表达式,之前求W)

此方法本质上是用其他列估计当前列的值(线性组合,其中权重可以理解为当前未访问的item同其他用户已经访问过的item的相似度),对值为0的元素尤为重要,填完矩阵后,再根据各个元素的得分,就可进行排序(point-wise)。 (与其他物品越相似,所得到score越高,越应该被推荐)

收获和启发

源码下载 http://www-users.cs.umn.edu/~xning/slim/html/

关于W元素非负

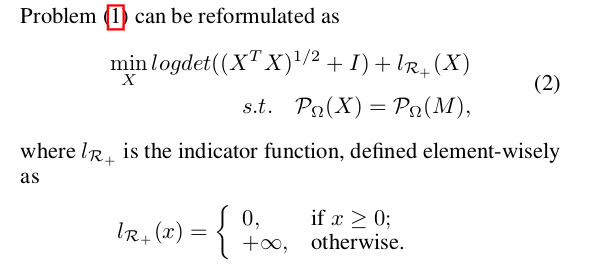

在训练时设置,如果Wij < 0 , 则强制增加该元素的loss value; 或者加一个限制项,如

该文中有个论点值得商榷

他认为直接将unknown item置为0效果会更好, 而且有其他学者也这么认为

| 文献题目 | 去谷歌学术搜索 | ||||||||||

| SLIM : Sparse Linear Methods for Top-N Recommender Systems | |||||||||||

| 文献作者 | Xia Ning and George Karypis | ||||||||||

| 文献发表年限 | 2011 | ||||||||||

| 文献关键字 | |||||||||||

| Top-N Recommender Systems, Sparse Linear Meth- ods, l1 -norm Regularization | |||||||||||

| 摘要描述 | |||||||||||

| This paper focuses on developing effective and efficient algorithms for top-N recommender systems. A novel Sparse LInear Method ( SLIM ) is proposed, which generates top- N recommendations by aggregating from user purchase/rating profiles. A sparse aggregation coefficient matrix W is learned from SLIM by solving an l1 -norm and l2 -norm regularized optimization problem. W is demonstrated to produce high- quality recommendations and its sparsity allows SLIM to generate recommendations very fast. A comprehensive set of experiments is conducted by comparing the SLIM method and other state-of- the-art top-N recommendation methods. The experiments show that SLIM achieves significant improvements both in run time performance and recommendation quality over the best existing methods. | |||||||||||